c为语义信息:如”一直猫在奔跑”,”一辆火车在运行”

问题:如果只训练正样本对(语义信息和图像信息匹配) 对于网络生成的负样本缺乏抑制(“猫”,火车的图),则网络可能生成与原来预想的不同的图像

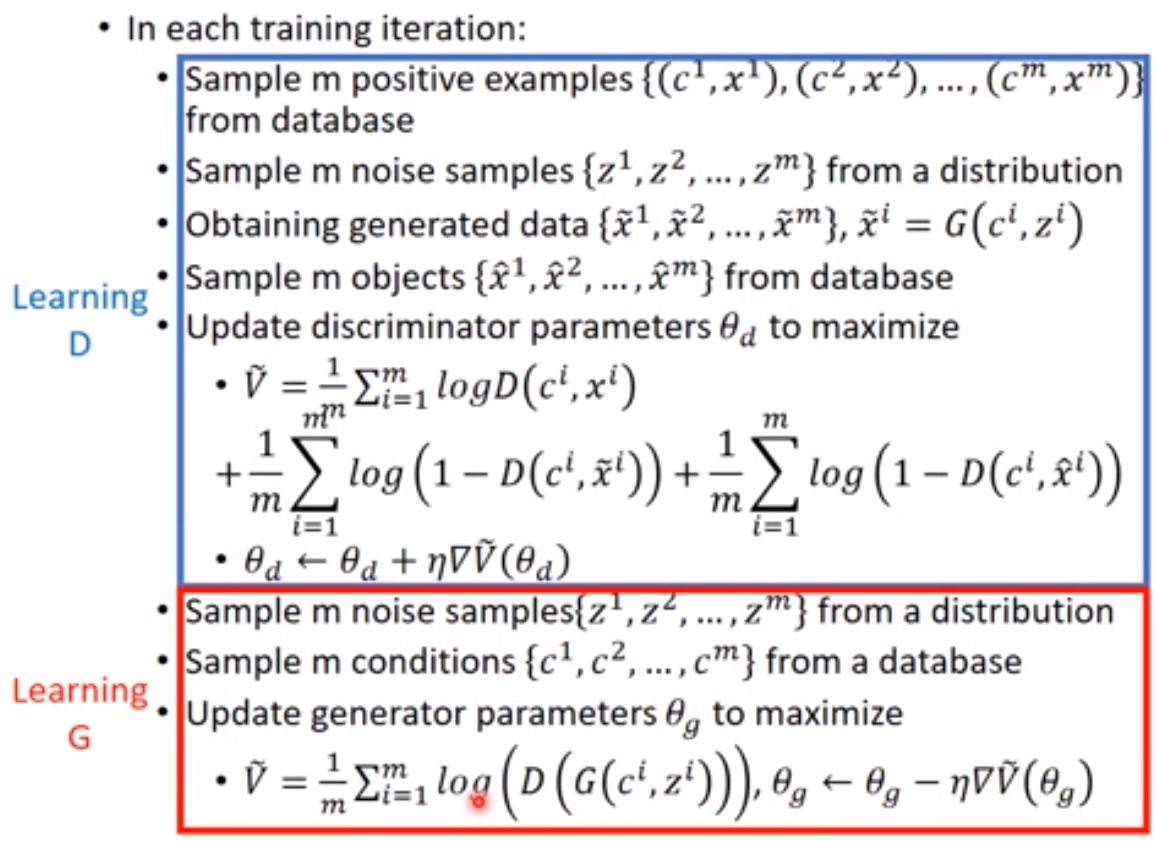

针对这个问题 提出了方法如上图

1 采样了m个正_样本对(语义信息和图像的内容匹配正确)(ci,xi)

2 通过generater生成的m个图与c的样本对(ci,~xi)

3 采样训练集的m个图与c的负_样本对(ci,^xi)

一、训练discriminater时

为了让loss=˜V更小

第一项logD(ci,xi)趋近于0则D(ci,xi)趋近于1,那么通过梯度反向传播更新后的权重对于之后输入的正样本对输出更加接近于1

第二项log(1−D(ci,~xi))趋近于0则1−D(ci,~xi)趋近于1,则D(ci,~xi)趋近于0,更新后的权重对于之后generater生成的图和正确语义信息的样本对输出更加接近于0

第三项log(1−D(ci,^xi))趋近于0则1−D(ci,^xi)趋近于1,则D(ci,^xi)趋近于0,更新后的权重对于之后输入图和错误语义信息的负样本对输出更加接近于0

则我们的判别器能更好的判别出图像对是正样本还是生成器生成的图像对,同时抑制了负样本对的生成

二、训练generater时

为了让loss=˜V更小

logD(G(ci,xi))趋近于0则D(G(ci,xi))趋近于1,那么通过梯度反向传播更新后的generater的权重生成的图喂给暂时被冻结了权重的判别器会输出”正”的判例

则我们的生成器能更好的生成出图像对接近正样本分布(因为此时判别器已经无法判断生成器生成的图像和真实图像)

大佬是搞CV的吗

我是蒟蒻,写这个只是想写一下自己看的东西

??