其实梯度消失不是RNN的特性缺点,而且一切深度神经网络的共性。因为求导的链式法则和非线性激活函数的选择直接影响了梯度的反向传播,这样话,就导致约靠前的网络学习越慢,很难训练。只不过由于RNN中由于不断的乘以相同的权重矩阵导致其梯度消失问题更显著。

对于非RNN的深度神经网络如前馈神经网络与卷积神经网络,为了解决梯度消失问题,通常可以引入更直接的联结使得梯度更容易传递。

好吧,这里我们估计已经可以大声喊出那个人的名字——Kaiming He!

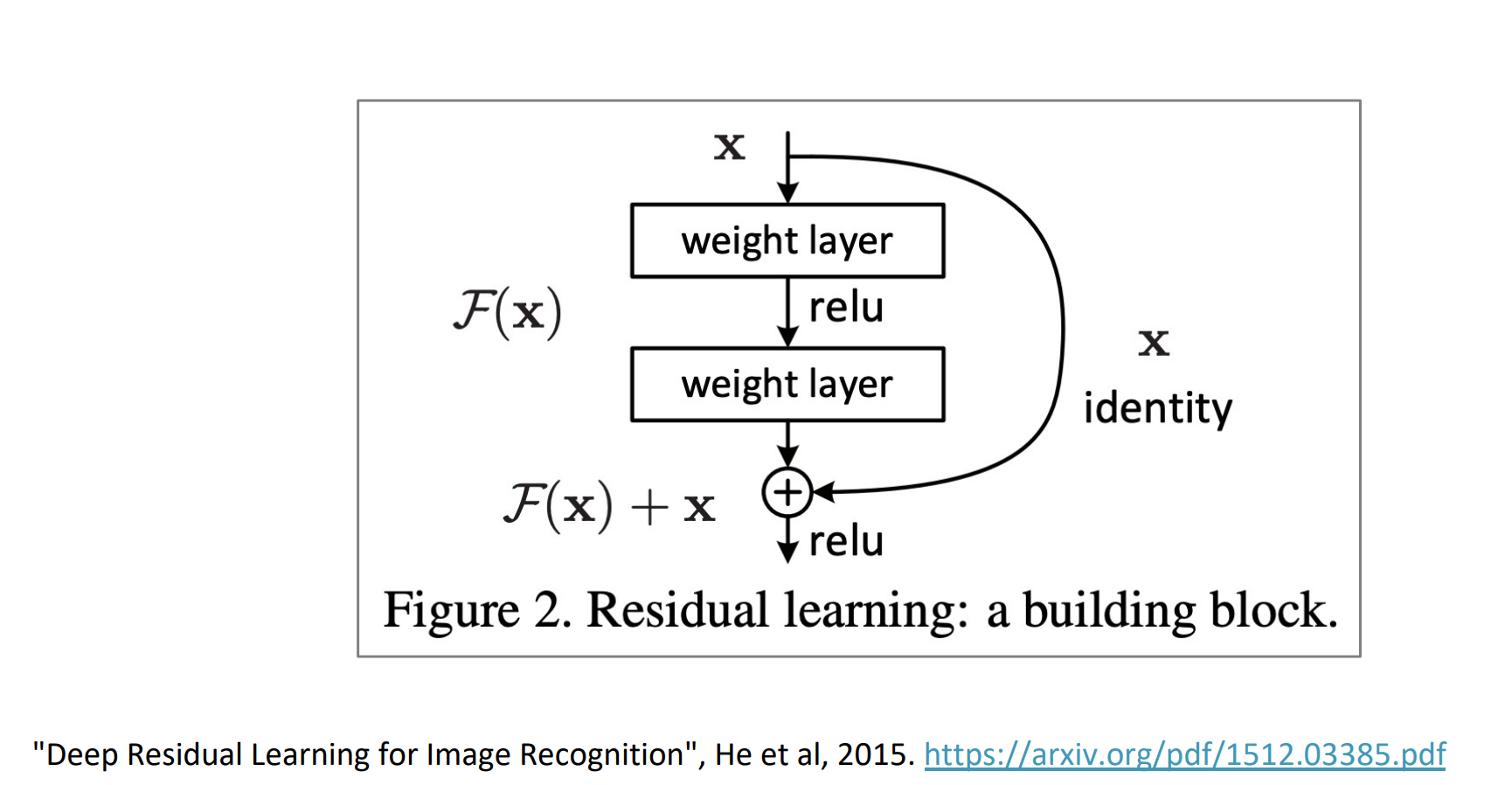

大名鼎鼎的残差网络(跳跃连接)就是把输入本身作为一个更直接的连接,Residual Connection也就是Skip Connection。——ResNet

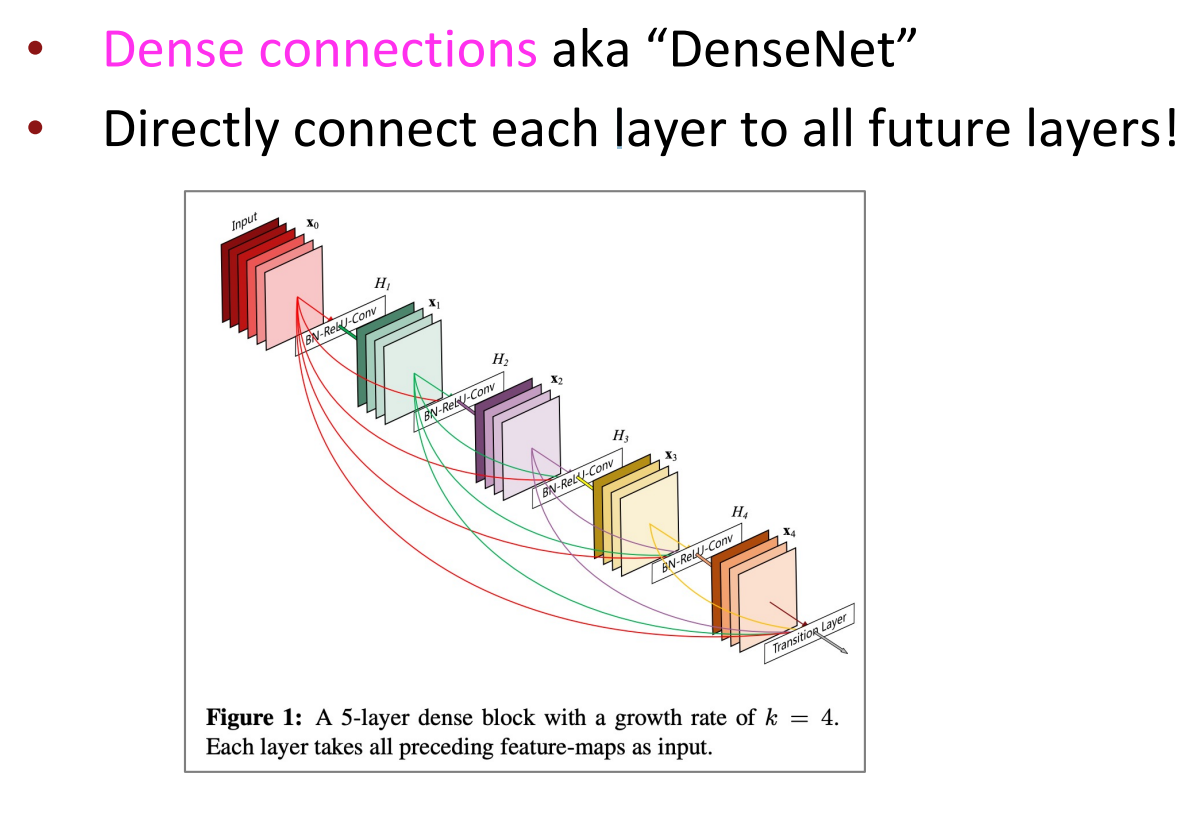

更进一步的,在DenseNet中,我们可以将几层之间全部建立直接联结,形成dense connection。

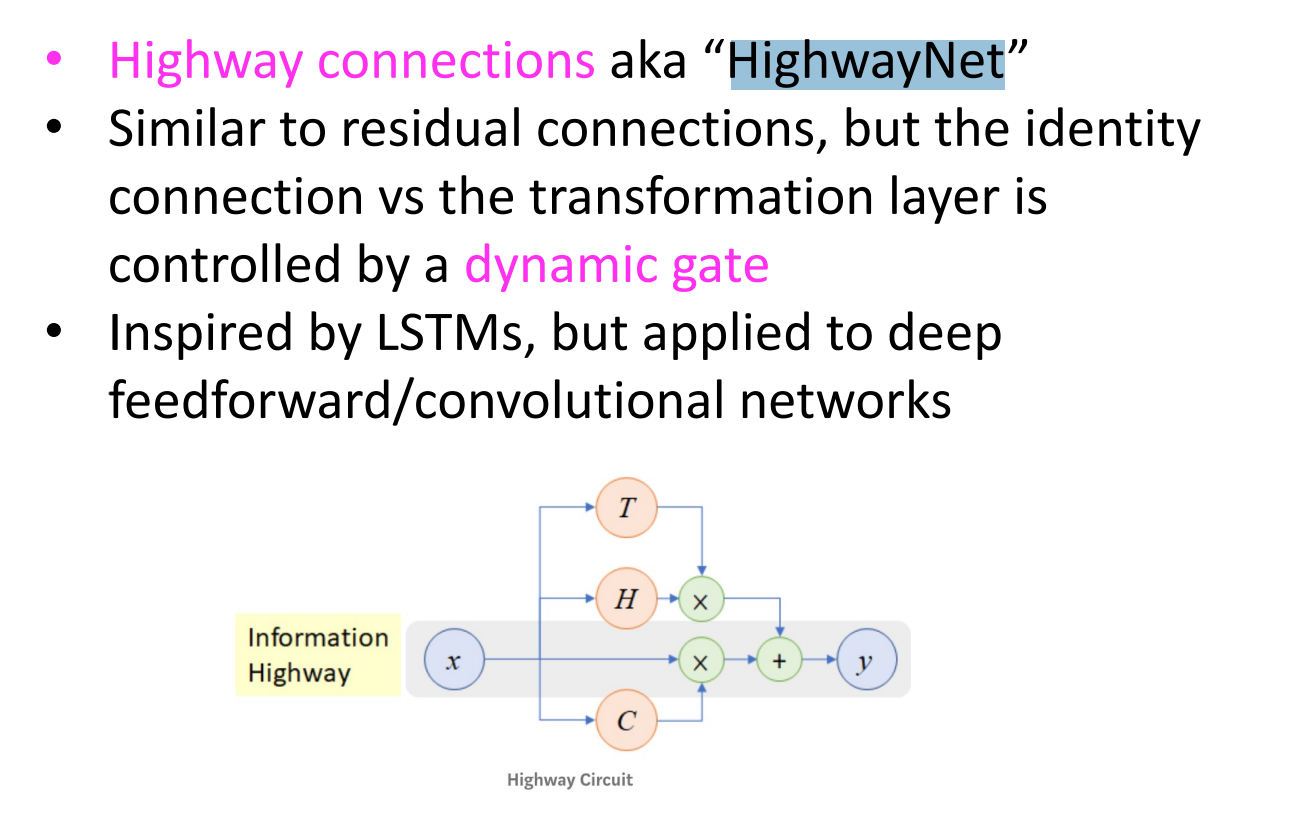

还有受到lstm的启发,不像resnet那么直接的x,而是用动态门控机制控制一下连接。叫HighwayNet

参考

https://zhuanlan.zhihu.com/p/63557635

https://web.stanford.edu/class/cs224n/